本文目录

问:

我想将强化学习融合到移动机器人(如扫地机器人等)的运动控制中,我该如何去思考这种可行性,请你给我一条可能的方向,并具体的给出一些你的思考

Deepseek答:

思考过程:

嗯,用户想将强化学习应用到移动机器人,比如扫地机器人的运动控制中。首先,我需要理解他们的需求和背景。可能他们有一定的机器人学或编程基础,但不太清楚如何结合强化学习。他们可能需要一个明确的方向和一些具体的思考点来开始项目。

我应该先考虑移动机器人运动控制的关键任务,比如路径规划、避障、动态环境适应等。然后想想强化学习在这些任务中的应用潜力。可能用户已经知道传统方法如PID控制、SLAM,但想探索更智能的自适应方法。

接着,要分析融合强化学习的可行性。这包括强化学习的优势,比如处理动态环境和通过试错优化策略,以及挑战,比如样本效率、实时性、安全性和泛化能力。可能需要具体例子来说明,比如DQN或PPO在避障中的使用,或者如何模拟训练环境来加速学习。

然后,思考用户可能未明说的需求。他们可能希望有一个实际的步骤指南,比如从仿真到实际部署的流程,或者如何处理安全性和现实中的各种噪声。此外,用户可能需要比较不同强化学习算法的优缺点,以及如何设计奖励函数,这是强化学习成功的关键。

最后,建议分阶段实施,从仿真验证开始,再实物测试,逐步迭代优化。同时,推荐相关的工具和框架,如ROS、Gazebo、PyTorch,帮助用户快速上手。还要提醒用户注意现实中的挑战,如传感器噪声、计算资源限制,以及如何确保安全约束,避免训练过程中损坏机器人。

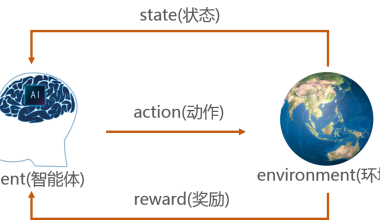

将强化学习(Reinforcement Learning, RL)与移动机器人运动控制结合是一个极具潜力的方向,但需要根据具体场景科学拆解问题。以下是一条可行方向的思考框架及具体实施建议:

核心思路:强化学习解决传统控制难以处理的非结构化场景

传统移动机器人控制(PID、MPC、基于规则的避障)在结构化环境(如固定障碍物、已知地图)中表现良好,但在动态复杂场景(如人群穿梭、未知地形、多目标优化)时可能失效。强化学习的优势在于通过自主学习建立环境响应策略,适合处理以下问题:

- 动态避障:如扫地机器人在儿童玩具随机散落的地面自主导航

- 能耗与效率平衡:自动调整运动策略以优化清扫覆盖率+续航时间

- 多模态决策:在楼梯边缘判断继续前进/后退/呼叫人工干预

具体实现路径(以扫地机器人为例)

1.问题建模

状态空间(State Space):激光雷达点云(降维至10-20个扇形区域)+ IMU姿态+剩余电量+历史路径(最后N个坐标)

动作空间(Action Space):离散化方向角(如左转15°/直行/右转15°) + 速度档位(低速/高速)

奖励函数(关键难点):

- 基础奖励:每分钟清扫面积 × 0.1

- 动态惩罚:碰撞惩罚-2(需区分轻微触碰与卡死),重复区域访问惩罚 × 衰减系数

- 长期奖励:剩余电量每10%额外+0.5(鼓励节能)

安全约束:靠近楼梯时激活额外负奖励-5

2.算法选择与优化

PPO算法(Stable Baselines3实现):适合连续动作空间且数据效率较高

模仿学习加速训练:

- 第一阶段用传统

A*算法生成10万条轨迹作为初始化经验池 - 第二阶段加入真实环境交互数据,采用HER(Hindsight Experience Replay)处理稀疏奖励问题

神经网络架构:

- 输入层:激光雷达数据用1D CNN提取空间特征(3层卷积,核大小[5,3,3])

- 中间层:LSTM处理时序依赖(隐含层128维)

- 输出层:使用GMM(高斯混合模型)生成平滑动作分布

3.仿真到现实的迁移(Sim2Real)

高保真仿真构建:

- 使用ROS+Gazebo建立动态环境模型,引入随机运动的虚拟行人(速度0.2-1.5m/s)

- 在Webots中模拟地毯摩擦力变化(μ=0.3到0.7随机扰动)

域随机化(Domain Randomization):

- 训练时随机化传感器噪声(激光测距±3cm误差)

- 随机化环境光照条件(影响视觉传感器)

实物系统关键优化:

- 部署时使用TensorRT加速模型推理(确保200ms内完成决策)

- 安全层设计:当RL输出动作导致IMU角速度突变>30°/s时触发EC刹车

典型挑战与应对策略

样本效率问题:

- 采用离线强化学习(Offline RL)预训练,初期仅用仿真数据即可达到70%基准性能

- 设计课程学习(Curriculum Learning),从简单空旷环境逐步过渡到复杂场景

现实安全风险:

- 双重控制系统:RL输出作为建议速度,由传统控制器计算最终执行指令

- 运行时验证(Runtime Verification):用线性时态逻辑(LTL)实时监测是否违反"始终可停于1米内"等安全规则

多目标权衡:

- 分层强化学习架构:底层控制负责避障,上层策略通过软性约束(如能耗权重λ)动态调整目标重要性

- 使用多目标PPO(MOPPO)生成Pareto前沿解集

验证指标设计

定量指标:

- 覆盖率(Coverage Rate):单位时间清扫面积/理论最大面积

- 风险指数:∑(危险距离 < 0.2m的持续时间) × 系数

- 能耗比:实际耗电量 / 理论最低耗电量(通过A*路径计算)

定性测试场景:

- 动态障碍测试:在8m×8m区域内投放10个随机运动气球(速度0.5m/s)

- 地形突变测试:在运行中突然铺设厚地毯(摩擦系数变化>40%)

工具链推荐

- 仿真平台:NVIDIA Isaac Sim(支持物理精确模拟)

- RL框架:Ray RLlib(支持分布式训练)

- 嵌入式部署:ROS2 + ONNX Runtime(轻量化部署)

- 硬件原型:选用Jetson Orin+NX+二维激光雷达(如RPLIDAR A3)

通过这个框架,可在6-8个月内构建出原型系统。初期建议从「仿真环境避障」小目标切入,逐步扩展到多任务协同。需要注意现实场景的数据闭环建设——建议设计自动标注系统(如通过机器人实际碰撞记录反标失败轨迹)。